下载项目代码

git clone https://github.com/THUDM/ChatGLM-6B.git

创建虚拟环境,建议使用 conda 管理

conda create -n chatglm python==3.8

安装依赖

conda activate chatglm

pip install -r requirements.txt

conda install cudatoolkit=11.7 -c nvidia

PS:没有安装

cudatoolkit的话,会报RuntimeError: Library cudart is not initialized错误但 issues 里也有人说可以通过使用CPU输出量化模型后直接调用的方式解决,暂未尝试。

硬件需求

| 量化等级 | 最低 GPU 显存(推理) | 最低 GPU 显存(高效参数微调) |

|---|---|---|

| FP16(无量化) | 13 GB | 14 GB |

| INT8 | 8 GB | 9 GB |

| INT4 | 6 GB | 7 GB |

修改一下启动参数

model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().cuda()

使用量化模型

# 按需修改,目前只支持 4/8 bit 量化

model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).quantize(4).half().cuda()

下载模型和启动 Gradio 界面

cd ChatGLM-6B

python web_demo.py

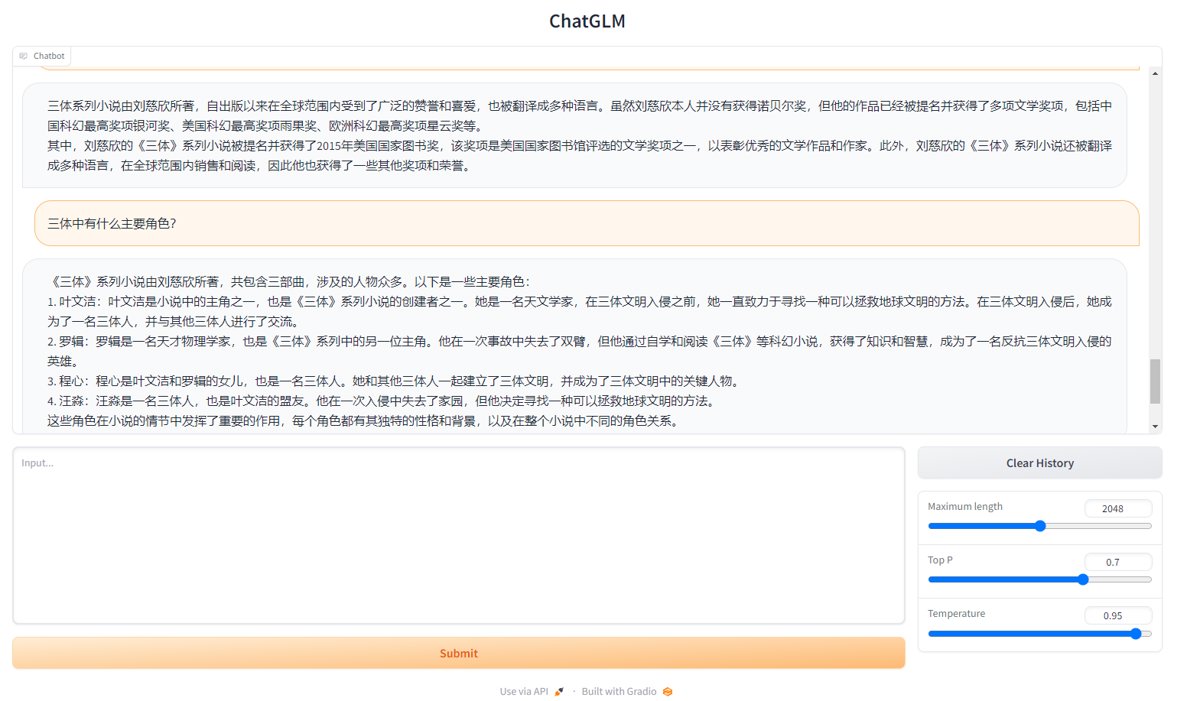

运行效果

程序设计实验室

微信公众号

程序设计实验室

微信公众号